María Mestres

En el mundo actual, los modelos de aprendizaje automático (ML) están impulsando la innovación en una amplia variedad de sectores. Sin embargo, uno de los grandes retos a los que se enfrentan los equipos de ciencia de datos es cómo gestionar el ciclo de vida completo de los modelos ML, desde el desarrollo hasta la producción. Aquí es donde entra en juego MLOps.

¿Qué es MLOps?

MLOps (Machine Learning Operations) es la práctica que une los principios de DevOps con el desarrollo y despliegue de modelos de machine learning. El objetivo principal es automatizar y optimizar las fases de construcción, entrenamiento, implementación y monitoreo de los modelos.

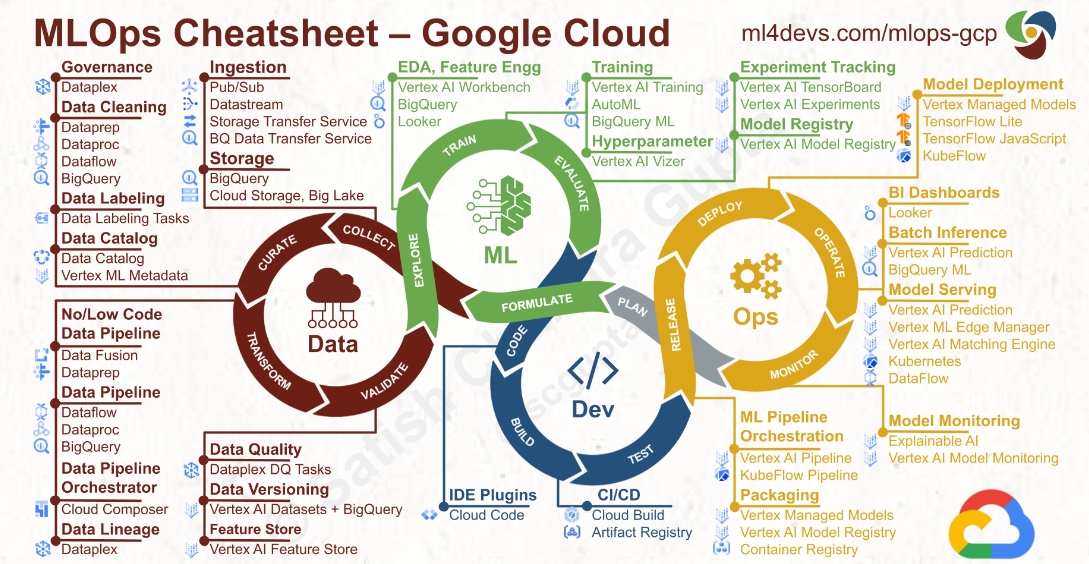

Google Cloud ofrece un conjunto de herramientas potentes que facilitan la implementación de MLOps de manera eficiente, escalable y segura.

Automatización del pipeline de ML

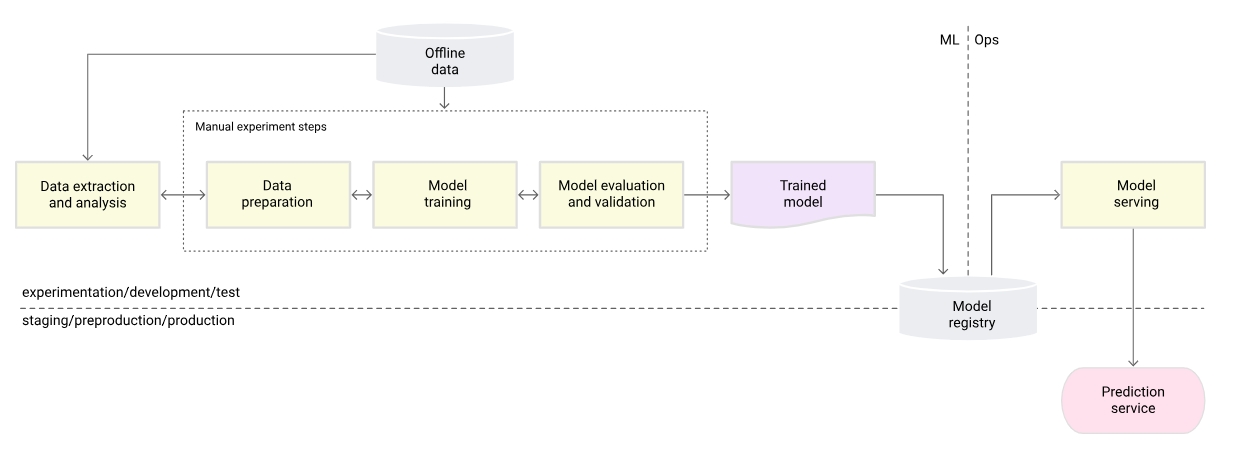

Los pasos clave del proceso de MLOps se basan en la integración de las mejores prácticas de DevOps con el ciclo de vida de machine learning, haciendo uso de herramientas como Google Cloud. Cada paso está orientado a la gestión y automatización del desarrollo, despliegue y monitoreo de modelos de machine learning.

1. Extracción y análisis de datos

- Descripción: El primer paso es la extracción, ingesta y análisis de los datos. Esto involucra obtener datos de diversas fuentes (como bases de datos, APIs, archivos, etc.) y almacenarlos de forma accesible para su procesamiento.

- Herramientas de Google Cloud:

- BigQuery para la extracción y consulta de grandes volúmenes de datos.

- Cloud Storage para almacenar grandes cantidades de datos no estructurados.

- Dataflow o Dataproc para el procesamiento distribuido de datos.

- Desafíos: Garantizar la calidad de los datos, manejando datos faltantes, anómalos o no estructurados. Asimismo, es fundamental implementar sistemas de versionado de datos para mantener consistencia durante el ciclo de vida del modelo.

2. Preparación de los datos

- Descripción: En este paso se lleva a cabo la limpieza, transformación y enriquecimiento de los datos. Se puede requerir la normalización, codificación de variables categóricas o la creación de nuevas características.

- Herramientas de Google Cloud:

- Dataflow: Ideal para el procesamiento de datos a gran escala en flujos por lotes o en tiempo real.

- Dataprep: Herramienta para la preparación visual e interactiva de datos.

- TFX (TensorFlow Extended): Facilita la creación de pipelines de datos reproducibles y escalables.

- Desafíos: La preparación de datos puede ser costosa en términos de tiempo y recursos, especialmente si los datos cambian con frecuencia. Es importante automatizar los procesos de transformación para evitar problemas de datos inconsistentes.

3. Entrenamiento del modelo

- Descripción: Es el proceso de entrenar un modelo de machine learning utilizando los datos pre procesados. Durante esta fase, se experimenta con diferentes algoritmos, hiper parámetros y técnicas de optimización.

- Herramientas de Google Cloud:

- Vertex AI o AI Platform: Plataformas que permiten entrenar modelos utilizando infraestructura gestionada de manera escalable.

- Kubernetes Engine (GKE): Para distribuir y escalar entrenamientos complejos mediante contenedores.

- Desafíos: La elección correcta de algoritmos, la búsqueda de hiper parámetros óptimos y la optimización del uso de recursos durante el entrenamiento son desafíos clave. Además, es importante garantizar la reproducibilidad de los experimentos.

4. Evaluación y validación del modelo

- Descripción: Tras el entrenamiento, es crucial evaluar el modelo para verificar su rendimiento. Se utilizan técnicas como la división en conjuntos de entrenamiento, validación y prueba, así como métricas de evaluación (precisión, recall, F1, etc.).

- Herramientas de Google Cloud:

- Vertex AI Model Monitoring: Permite monitorear el rendimiento de los modelos en el tiempo y detectar el drift de los datos.

- TensorFlow Model Analysis (TFMA): Una herramienta para el análisis de modelos de machine learning.

- Desafíos: Evitar el sobreajuste (overfitting) y subajuste (underfitting), asegurar que el modelo sea lo suficientemente generalizable y establecer las métricas correctas para evaluar el rendimiento del modelo.

5. Registro del modelo

- Descripción: Una vez entrenado y validado, el modelo debe ser versionado y almacenado en un registro central. Esto permite tener control sobre las versiones y asegurar que el modelo adecuado esté disponible para despliegue.

- Herramientas de Google Cloud:

- Vertex AI Model Registry: Permite registrar, versionar y gestionar los modelos, incluyendo metadatos sobre su entrenamiento y evaluación.

- Artifact Registry: Un repositorio para almacenar artefactos y contenedores de modelos.

- Desafíos: Asegurar que los modelos estén debidamente versionados y que se registren con suficiente información para su trazabilidad (fecha de entrenamiento, conjunto de datos utilizado, métricas, etc.).

6. Despliegue del modelo

- Descripción: El modelo entrenado y registrado se despliega en un entorno de producción para ser utilizado en la toma de decisiones. Esto puede incluir un entorno en línea para predicciones en tiempo real o por lotes.

- Herramientas de Google Cloud:

- Vertex AI Prediction: Para desplegar modelos en producción como servicios escalables que pueden recibir solicitudes en tiempo real.

- Google Kubernetes Engine (GKE): Ideal para gestionar el despliegue de modelos mediante contenedores.

- Cloud Functions/Cloud Run: Para ejecutar aplicaciones sin servidor que soportan modelos ligeros.

- Desafíos: Garantizar que los modelos sean escalables, altamente disponibles y que cumplan con los requisitos de latencia. Es crucial contar con procesos de rollback y testing para evitar despliegues defectuosos.

7. Monitoreo del modelo en producción

- Descripción: Después del despliegue, es fundamental monitorear el rendimiento del modelo para asegurar que siga funcionando como se espera. Esto incluye monitorear la calidad de las predicciones, el rendimiento del sistema y el drift de datos.

- Herramientas de Google Cloud:

- Vertex AI Monitoring: Permite monitorear la deriva (drift) en los datos y el rendimiento del modelo en producción.

- Cloud Monitoring: Para supervisar la infraestructura y asegurar que los servicios de predicción estén funcionando correctamente.

- AI Platform Prediction: Ofrece visibilidad sobre las métricas en línea de los modelos desplegados.

- Desafíos: Detectar rápidamente problemas en el rendimiento del modelo y garantizar que los modelos no se degraden con el tiempo a medida que los datos cambian.

Beneficios de usar Google Cloud para MLOps

- Escalabilidad automática: Google Cloud ajusta los recursos según la carga de trabajo, lo que es ideal para modelos ML que requieren grandes cantidades de cómputo.

- Seguridad: La seguridad integrada de Google Cloud asegura tus datos y modelos durante todo el ciclo de vida.

- Colaboración eficiente: Herramientas como Vertex AI permiten que los equipos de ciencia de datos, DevOps e ingeniería de datos trabajen en conjunto, compartiendo modelos y resultados de manera eficiente.

- Monitoreo en tiempo real: Google Cloud ofrece integraciones con herramientas como Cloud Monitoring y AI Platform Prediction, lo que te permite monitorear el rendimiento y detectar desviaciones o problemas en los modelos en tiempo real.

Conclusión

Implementar MLOps en Google Cloud no solo mejora la eficiencia y la escalabilidad, sino que también reduce los riesgos asociados al despliegue de modelos en producción. Gracias a las potentes herramientas de Google Cloud como Vertex AI, BigQuery ML y GKE, los equipos pueden optimizar el ciclo de vida completo de los modelos ML, desde el desarrollo hasta el monitoreo en producción.

Si estás buscando llevar tus modelos de machine learning al siguiente nivel, Google Cloud es la plataforma ideal para implementar MLOps de manera eficaz.